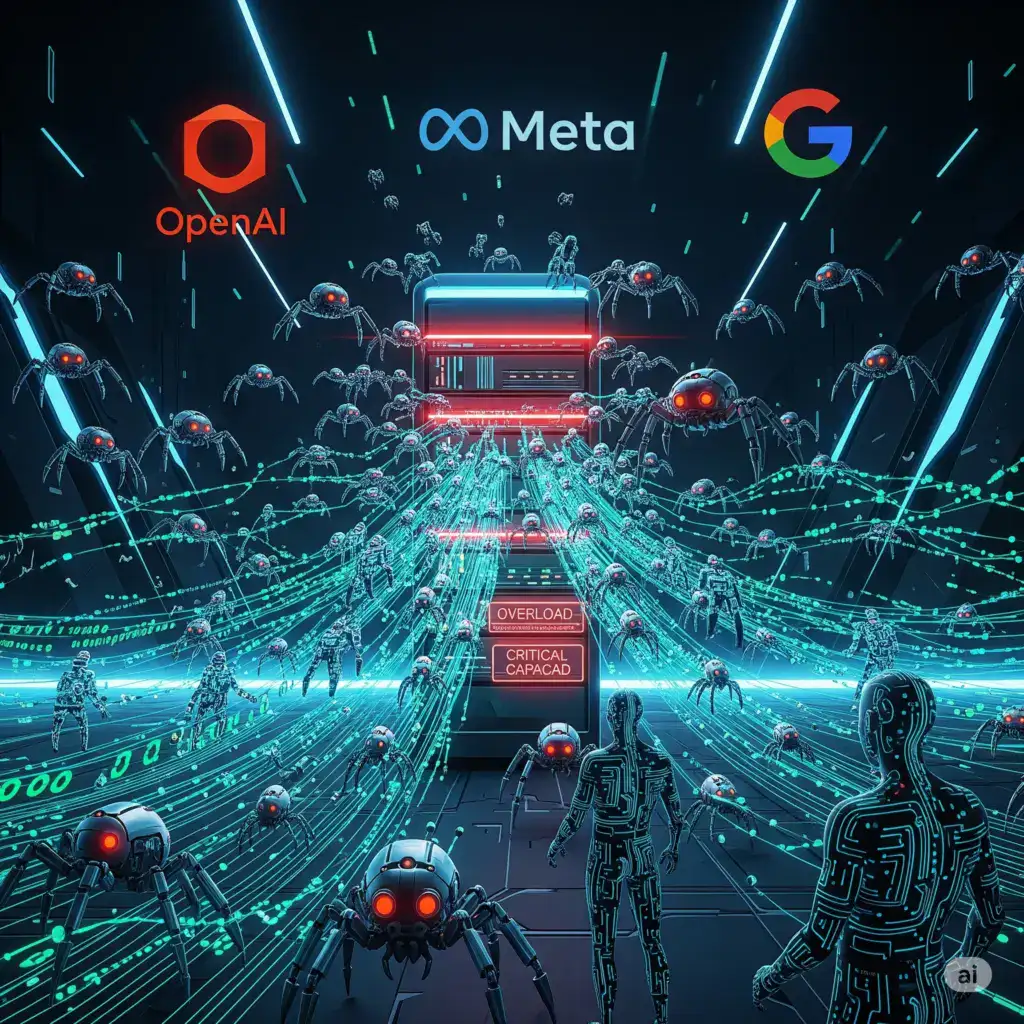

Relatório aponta “inundação” de bots de IA na web

Segundo a Fastly, 80% desse tráfego vem de crawlers, enquanto os outros 20% correspondem a sistemas de busca sob demanda. OpenAI lidera disparada.

Um relatório divulgado pela Fastly, empresa de serviços de CDN e segurança, revela um cenário alarmante sobre o tráfego web atual: a internet está sendo “inundada” por bots de inteligência artificial. Segundo os dados, 80% do tráfego gerado por IAs vem de crawlers — robôs que vasculham e copiam conteúdos de sites para treinar modelos, alimentar ferramentas de busca ou estruturar bases de dados. Os outros 20% são formados por sistemas que fazem requisições sob demanda, como assistentes e chatbots.

O estudo acende um alerta sobre a pressão crescente que essas IAs impõem à infraestrutura digital global, especialmente em sites menores ou com hospedagem compartilhada.

Quase tudo vem de três gigantes

O relatório indica que Meta, Google e OpenAI concentram 95% da atividade de crawlers de IA atualmente. O dado mais surpreendente, porém, é o papel da OpenAI: a empresa responde sozinha por quase 98% das requisições feitas por sistemas de busca sob demanda — ou seja, interações como “navegue esse site”, “busque esse conteúdo” ou “resuma essa página”.

Essa presença dominante mostra o quanto modelos como GPT-4, GPT-4o e ChatGPT têm se integrado ao fluxo informacional da web — muitas vezes sem aviso ou consentimento explícito dos donos dos sites.

Impactos críticos nos servidores

Bots bem projetados normalmente respeitam regras como o robots.txt, limites de taxa e horários de acesso. No entanto, segundo o relatório, muitos desses crawlers são mal configurados ou não otimizados, resultando em:

- Sobrecarga dos servidores

- Queda de performance em horários de pico

- Aumento de custos operacionais, especialmente em servidores pagos por uso (pay-per-request)

- Interrupções em APIs públicas e endpoints frágeis

Sites de pequeno e médio porte têm relatado tráfego suspeito vindo de IPs ligados a data centers de grandes nuvens, dificultando a filtragem e a mitigação sem afetar visitantes legítimos.

Debate ético e técnico

O avanço de bots de IA reacende o debate sobre uso justo de conteúdo online para fins de treinamento e indexação. Muitos sites que não foram projetados para servir dados a modelos de IA acabam sofrendo as consequências em forma de lentidão, consumo de largura de banda e até violação de termos de uso.

Com o crescimento de agentes autônomos, como o Meta AI, Google Gemini e ChatGPT com navegação, a tendência é de aumento ainda mais agressivo dessas requisições — o que pode forçar o mercado a repensar padrões de acesso, remuneração e controle sobre os dados públicos da web.

Você já percebeu acessos suspeitos em seu site ou servidor?

Compartilhe se já precisou bloquear bots de IA ou se acha que o uso de crawlers deveria ser mais transparente.

Fontes:

Relatório Fastly, TechCrunch, The Register, BleepingComputer, documentação de bots de IA