A OpenAI, referência global no campo da inteligência artificial, anunciou oficialmente nesta semana o lançamento de dois novos modelos: o3 e o4-mini. As novidades marcam um avanço significativo na capacidade das máquinas de interpretar imagens complexas e extrair insights contextuais a partir de conteúdo visual.

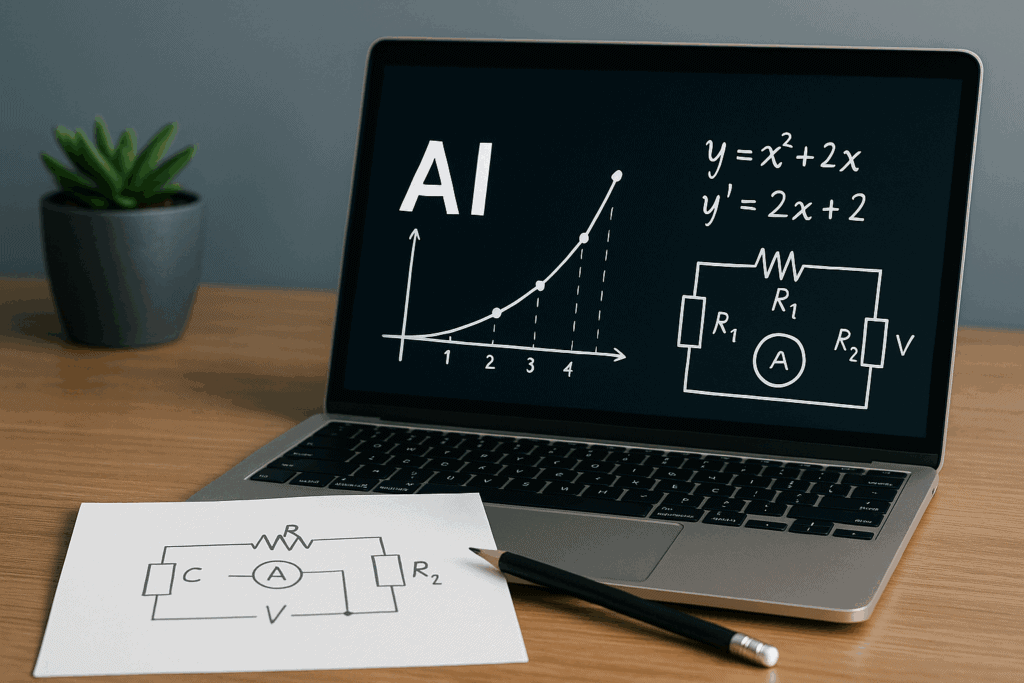

Voltados para aplicações educacionais, científicas e técnicas, os novos modelos são capazes de compreender e raciocinar com base em esboços, quadros brancos, gráficos, fluxogramas e até desenhos à mão livre. A promessa é transformar radicalmente áreas como ensino de matemática, engenharia, medicina e design digital.

Um salto na cognição visual da IA

Diferente de versões anteriores, os modelos o3 e o4-mini foram treinados com datasets multimodais — ou seja, que combinam texto, imagens e interações dinâmicas. Isso permite que o sistema vá além da simples descrição de uma imagem. Agora, ele é capaz de interpretar relações entre elementos visuais, prever intenções e até propor soluções com base em esquemas.

Por exemplo, ao receber uma imagem de um diagrama de circuito eletrônico incompleto, o modelo pode sugerir correções ou prever como o circuito deveria ser fechado para funcionar. Em um quadro branco com fórmulas parciais, ele pode completar equações ou gerar gráficos correspondentes.

Aplicações no ensino e na ciência

Os modelos estão sendo testados em ambientes acadêmicos com resultados animadores. Universidades americanas relatam que o o3 já é capaz de auxiliar alunos com dificuldades em geometria e álgebra visual, interpretando cadernos digitalizados e oferecendo sugestões visuais em tempo real.

Em laboratórios, a IA mostrou habilidade para compreender representações de estruturas moleculares desenhadas à mão e propor alternativas sintéticas. Já em ambientes de design, pode converter rascunhos em vetores precisos ou protótipos interativos.

Computação mais leve com o o4-mini

Enquanto o modelo o3 é mais robusto e voltado a servidores em nuvem, o o4-mini foi criado para funcionar localmente em dispositivos com hardware limitado, como notebooks e tablets. Essa versão miniaturizada mantém boa parte da capacidade de raciocínio visual e textual, mas com menor consumo de recursos.

Segundo a OpenAI, essa abordagem democratiza o acesso a tecnologias de IA visual, especialmente para instituições educacionais e empresas de pequeno porte.

Privacidade e segurança em destaque

A OpenAI destacou que os novos modelos seguem rigorosos padrões de privacidade, especialmente em aplicações com dados sensíveis, como imagens médicas e dados escolares. Todo o sistema foi treinado com supervisão humana para evitar vieses e garantir interpretações éticas e contextuais.

Além disso, foram incluídas ferramentas de auditoria visual para que os usuários possam rastrear como e por que a IA chegou a determinadas conclusões com base nas imagens fornecidas.

Integração futura com o ChatGPT

Ainda não está disponível publicamente, mas a OpenAI confirmou que as capacidades dos modelos o3 e o4-mini serão integradas gradualmente ao ChatGPT e a outras ferramentas da empresa, como o DALL·E, Codex e Whisper. Isso vai permitir, por exemplo, que um professor digital desenhe um conceito no quadro branco virtual e peça para o sistema gerar uma explicação completa baseada no esboço.

E você, o que acha dessa evolução na interpretação visual das IAs? Já imaginou usar uma IA para analisar seus rascunhos ou ajudar nos estudos? Deixe sua opinião nos comentários e compartilhe esta notícia com quem se interessa por tecnologia e educação!

Fontes: OpenAI, MarketingProfs, The Verge, TechCrunch, Wired