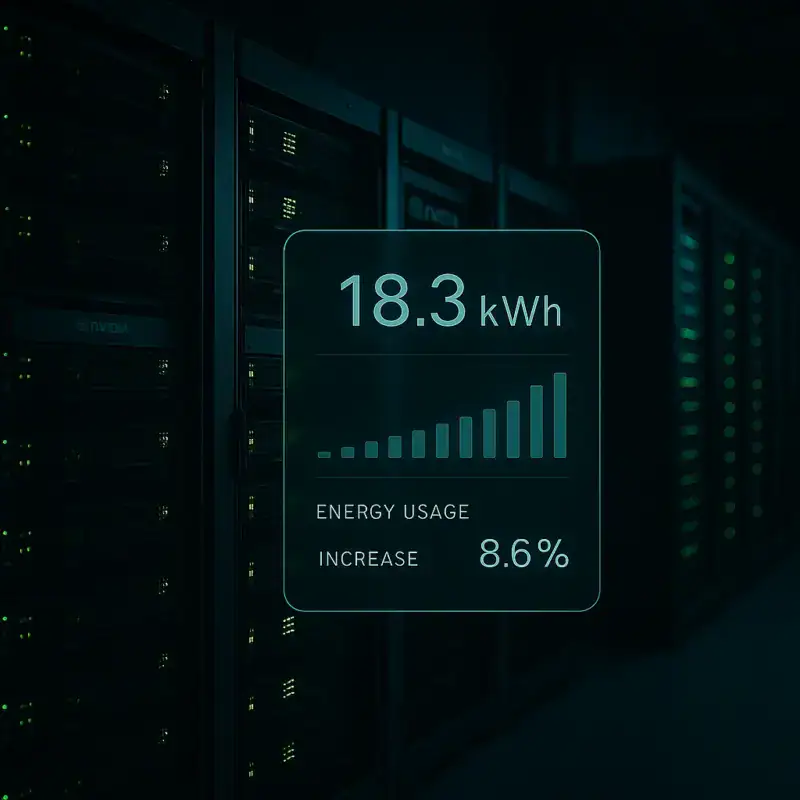

A promessa de uma inteligência artificial mais poderosa vem com um custo que muitos ainda não consideraram: o consumo de energia. Um estudo recente apontou que o GPT-5, novo modelo da OpenAI, pode estar consumindo em média 18,3 Wh para gerar uma resposta de 1.000 tokens — o equivalente a cerca de 750 a 800 palavras. Para efeito de comparação, o GPT-4 realiza a mesma tarefa utilizando apenas 2,12 Wh, o que representa um aumento de até 8,6 vezes no gasto energético.

Um salto de eficiência… e de consumo

Essa estimativa levanta questões importantes sobre a sustentabilidade da corrida por modelos de linguagem cada vez maiores. O estudo não tem acesso direto aos sistemas da OpenAI, mas baseou seus cálculos em três pilares:

- O tempo médio que o GPT-5 leva para responder,

- O provável hardware utilizado pela OpenAI nos servidores da Azure (como Nvidia DGX H100 ou H200),

- E o consumo médio estimado dessas máquinas durante operações intensivas de inferência.

Ou seja, os resultados não representam com precisão o consumo real, mas fornecem uma base relevante para refletirmos sobre os impactos ambientais da IA generativa em larga escala.

O custo invisível de cada pergunta

Para entender melhor, imagine que você pede ao GPT-5 um resumo de um artigo científico ou a criação de uma redação de 800 palavras. Essa ação isolada pode parecer inofensiva, mas se for multiplicada por milhões — ou até bilhões — de requisições por dia, o impacto energético se torna gigantesco.

Para ilustrar, 18,3 Wh é aproximadamente o que um laptop consome durante uma hora de uso moderado. Agora, pense em uma única resposta de IA exigindo essa mesma quantidade de energia. Em escala global, isso representa uma demanda crescente por data centers mais eficientes — ou mais numerosos — e levanta dúvidas sobre a real viabilidade ecológica de modelos cada vez mais sofisticados.

Entre a inovação e a responsabilidade

A OpenAI não comentou oficialmente os dados do estudo, e, por enquanto, a companhia não divulga publicamente o consumo energético detalhado dos seus modelos. No entanto, a especulação sobre o uso de servidores baseados em Nvidia H100 ou H200 reforça a hipótese de alto desempenho com custos proporcionais.

Essas GPUs são voltadas para tarefas de IA intensivas e fazem parte da infraestrutura da Microsoft Azure, que mantém uma parceria de longa data com a OpenAI. Embora essas placas ofereçam avanços em velocidade e capacidade de processamento, também são conhecidas por seu elevado consumo de energia, especialmente em cargas contínuas.

O desafio da próxima geração

Essa discussão nos lembra que cada avanço tecnológico traz consigo novas responsabilidades. Assim como os carros elétricos precisam equilibrar desempenho e impacto ambiental, as IAs precisam encontrar um meio-termo entre inteligência e eficiência energética.

Não é difícil imaginar um futuro em que o consumo energético será um critério tão importante quanto a qualidade das respostas. Afinal, de que adianta uma IA genial se ela contribui significativamente para o aumento da pegada de carbono global?

E você?

Você se preocupa com o impacto ambiental da inteligência artificial? Acha que as empresas de tecnologia deveriam divulgar mais dados sobre o consumo de seus sistemas? Compartilhe sua opinião com a gente nos comentários!

Fontes:

Bloomberg, TechCrunch, Wired, estudo publicado por pesquisadores independentes em julho de 2025